La définition et la mémorisation de l’information météorologique à l’échelle humaine se décomposent en deux périodes très distinctes : avant et après l’invention des instruments de mesure.

Avant la mesure, seuls les écrits fixent pour la postérité une information plus ou moins quantifiée (Cf. 2.1). En 1709, les archives nous apprennent, par exemple, que l’hiver a été très rigoureux : Louis XIV a traversé le Rhône à Tarascon avec son armée en traînant des canons ; un mètre de neige recouvrait les rues niçoises ; le vin gelait dans les tonneaux au fond des caves à Villars-sur-Var… Ces détails constituent une approche descriptive indirecte d’un événement. Avec la période instrumentale apparaissent des réseaux de mesure d’abord thermométrique et pluviométrique, avec des protocoles précis permettant de standardiser et donc de comparer les données. Dès la fin du 19e siècle apparaît ainsi le poste de l’Observatoire Longchamp à Marseille, mais c’est surtout à l’issue de la Seconde Guerre mondiale que vont se multiplier les postes de mesure pour satisfaire la demande croissante d’information météorologique émanant de l’activité aérienne, l’agriculture, le tourisme hivernal et estival, les transports, la gestion du risque… Les progrès de l’électronique ont aussi permis de fabriquer des stations météorologiques amateurs de plus en plus fiables et complètes à un moindre coût, ce qui a encouragé la naissance de réseaux amateurs capables d’apporter des observations complémentaires à celles du

monde professionnel. L’apparition des satellites artificiels (Landsat, SPOT…) va également donner un nouvel élan à l’instrumentation, grâce aux capteurs passifs, détectant une large gamme de longueurs d’ondes, ou actifs (radars, par exemple), mais aussi aux capteurs au sol destinés à des applications de plus en plus pointues.

Mais la mesure ponctuelle terrestre, même effectuée en continu et répétée de proche en proche, présente l’inconvénient de laisser des espaces interstitiels sans information, ce qui signifie que la mesure enregistrée dans un contexte physico-environnemental local n’est a priori représentative que d’elle-même. La densité d’un réseau de mesures a des limites et la question de la spatialisation, c’est-à-dire de l’estimation en tout de point de l’espace, s’est vite posée afin de combler le « vide » de la manière la plus judicieuse.

Depuis les années 1970-80, de nombreux travaux ont été consacrés à cette problématique que l’on peut nommer pour simplifier « géostatistique » (Zoom 3). Dans cette démarche empirique, inductive, visant à attribuer la valeur la plus probable d’une variable à un point donné où la mesure est absente, deux familles de logiques différentes sont vite apparues.

ZOOM 3. Les deux logiques de la géostatistique

La géostatistique a pour objet « l’étude de tout phénomène quantitatif qui se développe de façon structurée dans l’espace et/ou le temps ». Elle se décompose en deux logiques :

L’une répond à la logique de l’autocorrélation spatiale qui consiste à attribuer à un point non documenté une valeur proche de celles de ses voisins documentés. Par exemple, dans le cas le plus simple, la valeur inconnue d’un point C, situé à mi-distance entre deux points A et B à valeur connue, sera égale à la moyenne de ces derniers : 10° en A et 6° en B, donc 8°C en C. Cela se complique quand on n’a plus affaire à un transect (une ligne), mais à une surface et quand on décide qu’il n’y a pas forcément de gradient linéaire entre les stations. Mais la logique fondamentale demeure : on s’appuie sur le principe qu’un point ressemble d’autant plus à un autre qu’il en est proche. C’est entre autres la logique du IDW (Inverse Distance Weight) omniprésent dans les systèmes d’information géographique (SIG), mais aussi celle des fonctions SPLINE ou encore des différentes formes de krigeage (Figure 6).

L’autre, déclinée sous le terme de « régressions environnementales », cherche des relations non pas entre les stations, mais avec leur environnement. Ce dernier est avant tout décrit par des caractéristiques d’ordre géographique, comme la latitude et la longitude, et topographique comme l’altitude, l’éloignement de la mer, l’exposition, la pente, l’encaissement relatif d’une vallée… Le choix de ces variables a évidemment en arrière-plan une connotation physique avec le poids exercé par la densité de l’air, le bilan radiatif, l’occurrence d’inversions thermiques… D’autres familles de descripteurs peuvent être prises en compte : végétation, matériaux urbains…

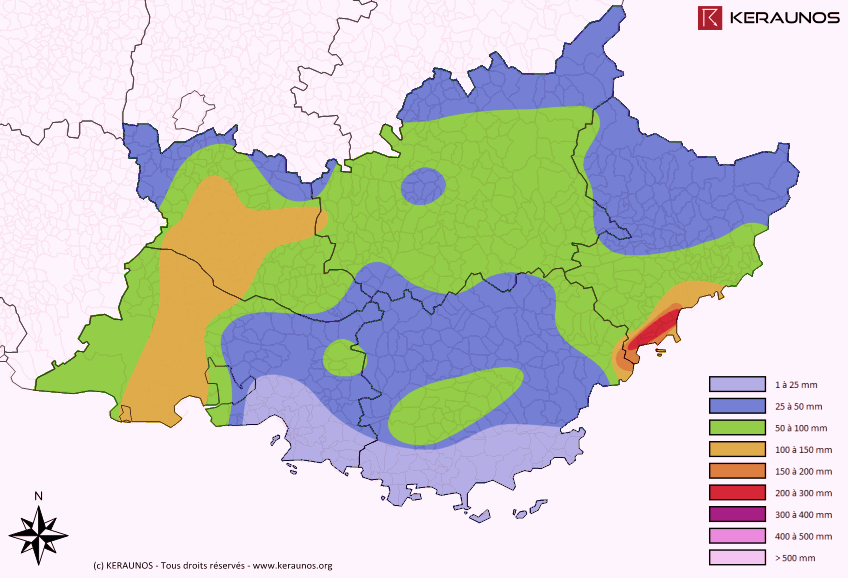

Figure 6. Lames d’eau mesurées en 24 heures le 3 octobre 2016 en PACA (Source : Keraunos)

Figure 6. Lames d’eau mesurées en 24 heures le 3 octobre 2016 en PACA (Source : Keraunos)

Ces deux approches s’appliquent généralement à des situations différentes (les régressions environnementales en cas de relief contrasté, par exemple), mais peuvent se combiner à certaines étapes du calcul : les résidus (écart entre valeur observée en un point et valeur recalculée par le modèle) d’une régression environnementale peuvent être soumis au krigeage, s’ils ont une structure spatiale.

A ces démarches empiriques, on peut opposer une autre approche, déductive, totalement différente, celle de la modélisation déterministe fondée sur les lois de la physique. Ici, pour reconstituer un champ d’une variable (températures, précipitations…), on n’utilise pas un jeu de données locales (mesures), mais les lois physiques qui gouvernent une variable en calculant celle-ci à chaque point d’une grille (ou chaque pixel) à partir de la densité de l’air, du bilan radiatif, de la conduction dans le sol, de l’advection (apport d’air) horizontale et verticale, de la chaleur latente libérée par la condensation ou consommée par l’évaporation… Cette logique permet en outre de prévoir à différents horizons temporels, puisqu’en établissant un premier bilan au temps T, appelé « état initial », il est possible de calculer un nouvel état à court, moyen ou long terme qui devient à son tour un nouvel état initial et ainsi de suite. C’est la base de la prévision météorologique moderne, avec une limite de l’ordre d’une semaine à dix jours pour la prospective à cause du caractère chaotique de l’atmosphère.

Sommaire du cahier