- 3.110. Les grandes évolutions du climat passé

-

3.158. Climat présent : la connaissance s'affine

- 3.158.103. Instrumentation et techniques de spatialisation des données

- 3.158.150. Le changement climatique est-il déjà une réalité ?

- 3.200. Résultats de données spatialisées à l’échelle locale et régionale

Avant d’anticiper le climat futur de la région Provence-Alpes-Côte d’Azur, il est important de rappeler quels sont ses climats passé et présent qui sont indissociables des bouleversements du système atmosphérique global. Le changement climatique actuel n’est pas la première fluctuation que connaît la région PACA dans son histoire, puisque le climat a continuellement évolué sur Terre. Les techniques de reconstitution du climat passé, l’instrumentation, les techniques de spatialisation et la modélisation ont grandement contribué à une meilleure connaissance du climat à toutes les échelles spatio-temporelles.

3.110. Les grandes évolutions du climat passé

Du dernier cycle glaciaire à notre cycle interglaciaire (Holocène)

Il existe en région Provence-Alpes-Côte d’Azur un très beau témoin de la variation du climat passé. Il s’agit de la grotte Cosquer, du nom de son découvreur (voir photo ci-dessus). Cette grotte se trouve à proximité de la calanque de Morgiou, au sud de Marseille. Sa valeur exceptionnelle réside dans l’ornementation de ses parois, recouvertes de peintures pariétales préhistoriques, datées d’environ 27 000 ans BP (Before Present) pour les « mains négatives » et de 19 000 ans BP pour le « bestiaire » (représentations d’animaux). Ces illustrations témoignent de la présence humaine dans cette grotte en ces temps reculés, autour de la dernière période glaciaire. Aujourd’hui, la grotte est inaccessible à pied, car son unique entrée est immergée à 37 mètres de profondeur. L’accès était possible à la dernière période glaciaire puisque le niveau marin était environ 120 mètres plus bas qu’aujourd’hui, découvrant falaises et plaines aujourd’hui submergées.

Nous savons aujourd’hui que le climat à l’échelle de la planète, appelé « climat global », lors de la dernière période glaciaire (environ 20 000 ans BP), était caractérisé par des températures moyennes globales de 4 à 5°C plus froides, des calottes polaires massives sur le nord de l’Europe et du Canada, une végétation adaptée aux conditions environnementales de l’époque… Le sud de la France abritait une végétation steppique parsemée d’îlots forestiers de pins, genévriers, bouleaux, avec des températures moyennes annuelles de 10 à 12°C plus basses que maintenant. Les paysages devaient ressembler aux pelouses alpines actuelles de haute montagne.

Ces variations climatiques majeures s’inscrivent dans une alternance connue sous le nom de cycles climatiques, oscillant depuis plus de deux millions d’années entre conditions glaciaires (« froides ») et interglaciaires (« chaudes »). La raison de ces variations est purement naturelle et principalement liée aux paramètres orbitaux de la Terre : sa position et surtout son inclinaison par rapport au soleil modifient l’insolation reçue, notamment au niveau des pôles et des hautes latitudes. Ces variations d’insolation aux hautes latitudes permettent ou préviennent la formation des calottes polaires. A cela s’ajoutent les effets de la dynamique interne imposée par l’atmosphère et l’océan qui régulent les flux de chaleur, tandis que l’océan et la biosphère interfèrent sur le cycle du carbone. Dans cette histoire du climat, le dioxyde carbone (CO2), par son action de gaz à effet de serre, est un amplificateur des changements.

Le réchauffement qui a suivi le dernier cycle glaciaire a démarré sous nos latitudes il y a 15 000 ans et a été brutal à l’échelle géologique. Il s’est opéré en deux phases de près de mille ans chacune. Si l’amplitude du réchauffement global était de 4 à 5°C, cela s’est traduit dans le sud de la France par un réchauffement de 10 à 12°C. Ces deux phases ont été séparées par un renversement brutal. C’était vers 13 000 ans BP. En effet, la fonte de la calotte de glace qui s’étendait sur une grande partie du Canada a provoqué un flux d’eau douce et froide suffisant pour bloquer la circulation océanique de l’Atlantique Nord (en particulier le Gulfstream et la dérive Nord-Atlantique bien connus en Europe) et engendrer un refroidissement sur une majeure partie de l’hémisphère Nord. Cette période, appelée « Dryas récent », a été marquée par le retour d’une végétation glaciaire en moins d’un siècle. Elle a duré un peu moins de 1000 ans. Le réchauffement qui a suivi, vers 12 000 ans BP, est le point de départ de la période interglaciaire actuelle appelée « Holocène », dont les conditions climatiques ont été relativement stables pendant dix millénaires.

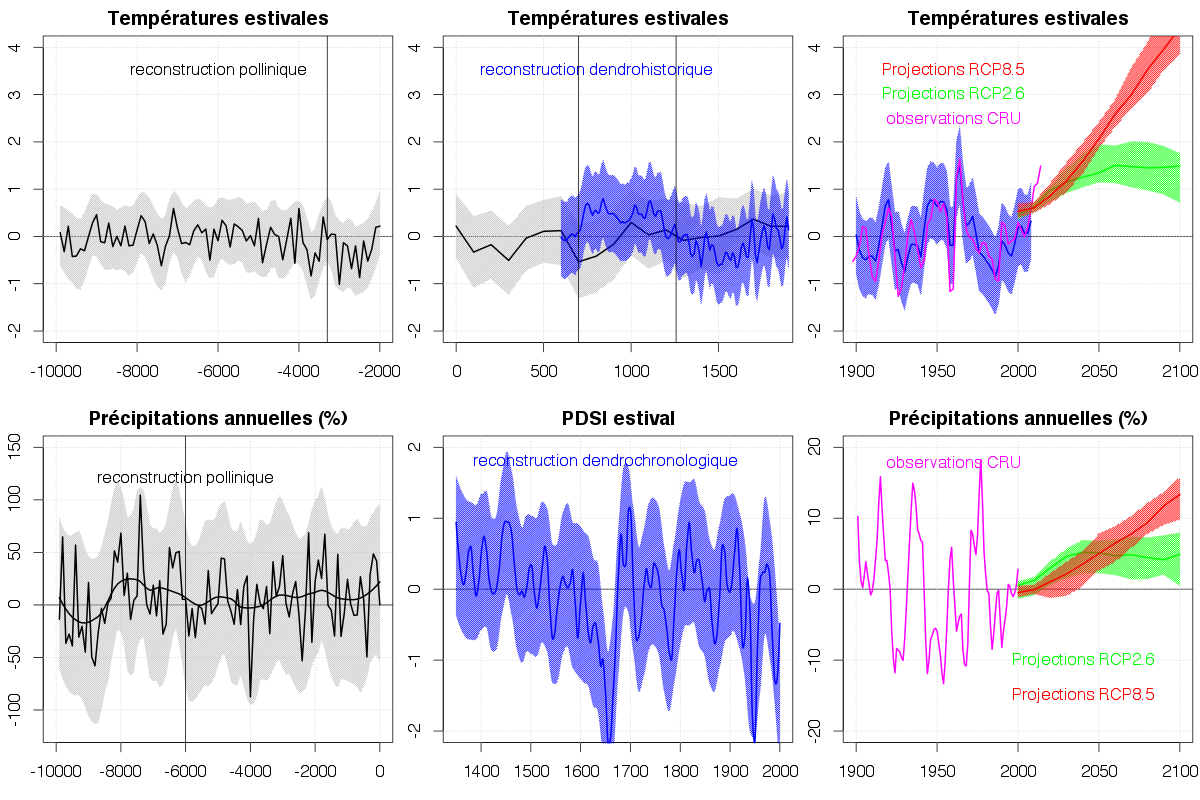

De notre cycle interglaciaire à la fin du 21e siècle

Dans notre région, comme partout ailleurs, les changements du climat, avant l’établissement des stations météorologiques, sont connus grâce à des indicateurs indirects. Pour l’Holocène, il s’agit principalement de fossiles liés à la flore, comme les grains de pollen émis chaque année par les plantes. Chaque espèce a une morphologie pollinique typique qu’il est possible de reconnaître au microscope. Le palynologue, le spécialiste du pollen, distingue par exemple les grains de pollen de pin ou de chêne, constitutifs d’une végétation forestière tempérée, des grains de pollen de graminées qui dominent dans les végétations steppiques froides. On peut finalement reconstruire, à partir de ces indicateurs, l’évolution des températures et des précipitations avec une résolution temporelle allant jusqu’au siècle (Figure 4). Durant le dernier millénaire, on accède à la variabilité interannuelle du climat grâce aux cernes d’arbres et aux archives historiques écrites. L’arbre produit un cerne annuel dont l’épaisseur est liée à la biomasse produite, elle-même dépendante des conditions climatiques. Les documents historiques dépouillés par les historiens contiennent une masse d’informations sur les climats depuis le Moyen Âge à travers des livres de comptes, d’annales, d’éphémérides… Toutes ces informations sont décodées grâce à des méthodes statistiques donnant des courbes d’évolution de la température ou d’autres indices climatiques.

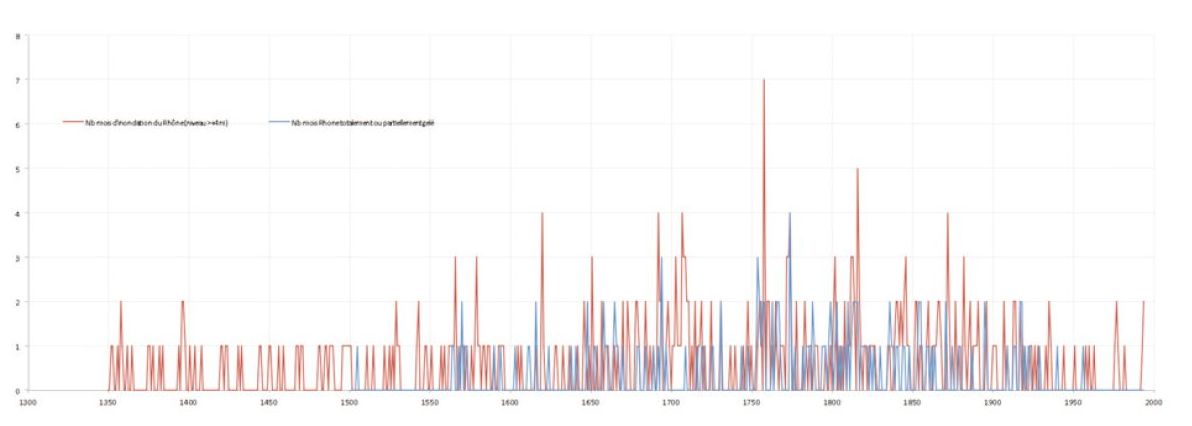

La Figure 4 montre que la gamme de variation des températures estivales n’a pas dépassé 1°C en valeur absolue sur tout l’Holocène avec une longue période plus chaude de 0,5°C entre 7000 et 4000 ans BP : c’est l’optimum climatique de l’Holocène moyen. La courbe des précipitations annuelles montre un relatif assèchement de l’ordre de 20% à partir de 6000 ans BP. A partir de 4000 ans BP, on observe un premier refroidissement suivi d’un second vers 3200 ans BP. Cette période est connue comme la fin de l’Âge du bronze en Méditerranée. Elle a été le témoin de nombreux troubles politiques principalement dans l’est de la Méditerranée avec la fin des civilisations mycénienne et hittite, et l’invasion des Peuples de la mer. Dans cette région, le changement climatique était surtout dû à l’aridité importante qui a duré près de trois siècles. Ensuite, le centre de gravité des civilisations méditerranéennes s’est déplacé vers la Grèce, puis l’Italie. Plus tard, le déclin de l’empire romain à la fin du 4e siècle est concomitant avec une période froide et humide. Le climat redevient chaud entre 700 et 1250 ans de notre ère : l’optimum médiéval est atteint.

A partir des années 1250, des éruptions volcaniques (dont celle du Salamas en Indonésie en 1257) sont vraisemblablement responsables de l’entrée dans le petit âge glaciaire (PAG), période froide et humide qui s’est prolongée jusqu’à la fin du 19e siècle, avec une accentuation liée à une baisse de l’activité solaire entre 1645 et 1715 (minimum de Maunder). Ce PAG est très probablement à l’origine de la grande famine qui a sévi de 1315 à 1317, de la propagation de la peste noire et de l’effondrement de la population. Il a aussi accentué l’effet de la Guerre de 30 ans (1618-1648). Les révolutions ont principalement des raisons sociopolitiques, mais le climat a souvent pu jouer un rôle déclencheur (par exemple, les mauvaises récoltes de 1787 à 1789 causées par un climat défavorable) ou amplificateur.

Si on compare les projections climatiques (Figure 4) basées sur le scénario socio-économique (Cf. partie 3.1) le moins émetteur en gaz à effet de serre (RCP 2.6) et le scénario le plus émetteur (RCP 8.5), on constate que l’évolution future des températures estivales dépassera largement ce que les hommes ont connu depuis 10 000 ans. Les projections concernant les précipitations sont plus incertaines, mais la question de la ressource en eau est bien plus complexe que le simple cumul de précipitations et tient compte notamment de la fréquence des précipitations et de leur intensité, mais aussi des ressources distantes : par exemple, les précipitations neigeuses dans les Alpes pour alimenter les fleuves et rivières qui drainent la région PACA.

Une perspective historique des températures (°C) et précipitations (mm) dans la zone couvrant la région PACA depuis 10 000 ans est donnée dans la Figure 4, le zéro étant la moyenne de la période 1961-1990 (normale de 30 ans) et les surfaces colorées représentant les incertitudes (dispersion autour de la moyenne).

Les observations CRU sont les interpolations sur une grille de 5° de longitude et 2,5° de latitude du Climate Research Unit à East Anglia, à partir de laquelle la sous-grille englobant la région PACA a été extraite.

La première ligne de graphiques indique les anomalies des températures moyennes de la période d’avril à septembre :

- les courbes noires/grises sont reconstruites à partir de données polliniques par intervalle de 100 ans, allant de 10 000 à 2000 ans BP ;

- les courbes bleues sont reconstruites à partir d’une compilation de données issues de cernes d’arbres (dendrochronologie), de données polliniques et de données historiques (AD signifie Anno Domini : années après Jésus-Christ) ;

- la courbe magenta représente les observations du Climate Research Unit ; la courbe verte représente le scénario socioéconomique RCP 2.6 et la courbe rouge, le scénario RCP 8.5.

La seconde ligne du graphique indique soit l’écart aux précipitations annuelles (en pourcentage des valeurs de référence), soit les indices estivaux de sécheresse (PDSI pour Palmer Drought Severity Index), les valeurs négatives indiquant des conditions plus sèches que la normale :

- les courbes noires/grises représentent les précipitations reconstruites à partir de données polliniques par intervalle de 100 ans, allant de 10 000 ans BP à 0 ;

- les courbes bleues représentent le PDSI estival reconstruit à partir de données de cernes d’arbres (dendrochronologie) ;

- la courbe magenta représente les précipitations annuelles observées par Climate Research Unit ; la courbe verte, le scénario RCP 2.6 et la courbe rouge, le scénario RCP 8.5.

La Figure 5 montre que le petit âge glaciaire a connu au moins un mois d’embâcle et des hauteurs d’eau nettement supérieures à la normale. Ceci signifie que le PAG était à la fois froid et pluvieux. Le maximum du PAG se situe entre 1650 et 1900, ce qui est confirmé par un indice PDSI supérieur à zéro mettant en évidence des conditions humides (Figure 4).

Le climat passé a donc connu des fluctuations importantes dues à des variations naturelles. Le climat terrestre n’est donc pas une composante figée, mais il oscille en permanence.

3.158. Climat présent : la connaissance s'affine

Avec l’émergence des instruments de mesures en météorologie dès la fin du 19e siècle, la connaissance du climat s’est considérablement enrichie. Aujourd’hui, de longues séries de données sont disponibles pour étudier localement l’évolution des variables climatiques. Le développement des techniques de spatialisation et de modélisation en 2D ou 3D ont permis de décrire les processus complexes qui conditionnent le climat à l’échelle locale et régionale.

3.158.103. Instrumentation et techniques de spatialisation des données

La définition et la mémorisation de l’information météorologique à l’échelle humaine se décomposent en deux périodes très distinctes : avant et après l’invention des instruments de mesure.

Avant la mesure, seuls les écrits fixent pour la postérité une information plus ou moins quantifiée (Cf. 2.1). En 1709, les archives nous apprennent, par exemple, que l’hiver a été très rigoureux : Louis XIV a traversé le Rhône à Tarascon avec son armée en traînant des canons ; un mètre de neige recouvrait les rues niçoises ; le vin gelait dans les tonneaux au fond des caves à Villars-sur-Var… Ces détails constituent une approche descriptive indirecte d’un événement. Avec la période instrumentale apparaissent des réseaux de mesure d’abord thermométrique et pluviométrique, avec des protocoles précis permettant de standardiser et donc de comparer les données. Dès la fin du 19e siècle apparaît ainsi le poste de l’Observatoire Longchamp à Marseille, mais c’est surtout à l’issue de la Seconde Guerre mondiale que vont se multiplier les postes de mesure pour satisfaire la demande croissante d’information météorologique émanant de l’activité aérienne, l’agriculture, le tourisme hivernal et estival, les transports, la gestion du risque… Les progrès de l’électronique ont aussi permis de fabriquer des stations météorologiques amateurs de plus en plus fiables et complètes à un moindre coût, ce qui a encouragé la naissance de réseaux amateurs capables d’apporter des observations complémentaires à celles du

monde professionnel. L’apparition des satellites artificiels (Landsat, SPOT…) va également donner un nouvel élan à l’instrumentation, grâce aux capteurs passifs, détectant une large gamme de longueurs d’ondes, ou actifs (radars, par exemple), mais aussi aux capteurs au sol destinés à des applications de plus en plus pointues.

Mais la mesure ponctuelle terrestre, même effectuée en continu et répétée de proche en proche, présente l’inconvénient de laisser des espaces interstitiels sans information, ce qui signifie que la mesure enregistrée dans un contexte physico-environnemental local n’est a priori représentative que d’elle-même. La densité d’un réseau de mesures a des limites et la question de la spatialisation, c’est-à-dire de l’estimation en tout de point de l’espace, s’est vite posée afin de combler le « vide » de la manière la plus judicieuse.

Depuis les années 1970-80, de nombreux travaux ont été consacrés à cette problématique que l’on peut nommer pour simplifier « géostatistique » (Zoom 3). Dans cette démarche empirique, inductive, visant à attribuer la valeur la plus probable d’une variable à un point donné où la mesure est absente, deux familles de logiques différentes sont vite apparues.

ZOOM 3. Les deux logiques de la géostatistique

La géostatistique a pour objet « l’étude de tout phénomène quantitatif qui se développe de façon structurée dans l’espace et/ou le temps ». Elle se décompose en deux logiques :

L’une répond à la logique de l’autocorrélation spatiale qui consiste à attribuer à un point non documenté une valeur proche de celles de ses voisins documentés. Par exemple, dans le cas le plus simple, la valeur inconnue d’un point C, situé à mi-distance entre deux points A et B à valeur connue, sera égale à la moyenne de ces derniers : 10° en A et 6° en B, donc 8°C en C. Cela se complique quand on n’a plus affaire à un transect (une ligne), mais à une surface et quand on décide qu’il n’y a pas forcément de gradient linéaire entre les stations. Mais la logique fondamentale demeure : on s’appuie sur le principe qu’un point ressemble d’autant plus à un autre qu’il en est proche. C’est entre autres la logique du IDW (Inverse Distance Weight) omniprésent dans les systèmes d’information géographique (SIG), mais aussi celle des fonctions SPLINE ou encore des différentes formes de krigeage (Figure 6).

L’autre, déclinée sous le terme de « régressions environnementales », cherche des relations non pas entre les stations, mais avec leur environnement. Ce dernier est avant tout décrit par des caractéristiques d’ordre géographique, comme la latitude et la longitude, et topographique comme l’altitude, l’éloignement de la mer, l’exposition, la pente, l’encaissement relatif d’une vallée… Le choix de ces variables a évidemment en arrière-plan une connotation physique avec le poids exercé par la densité de l’air, le bilan radiatif, l’occurrence d’inversions thermiques… D’autres familles de descripteurs peuvent être prises en compte : végétation, matériaux urbains…

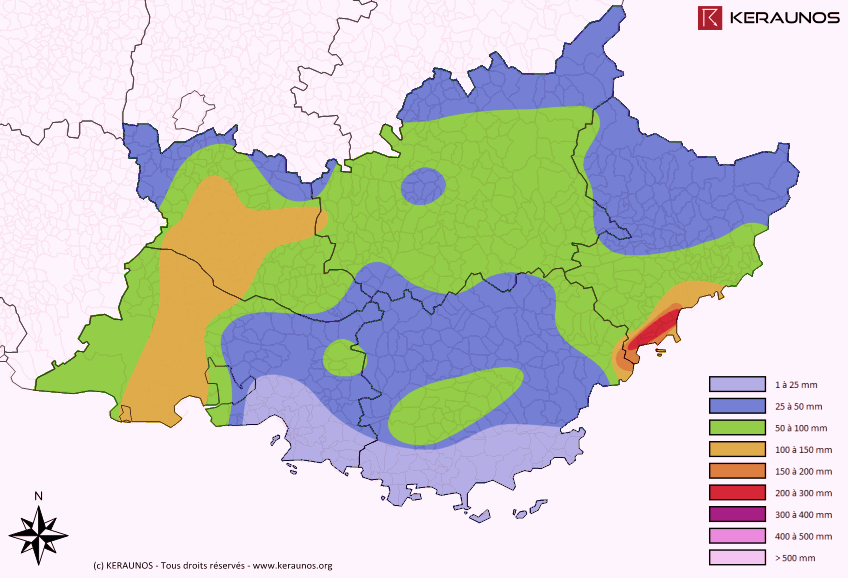

Figure 6. Lames d’eau mesurées en 24 heures le 3 octobre 2016 en PACA (Source : Keraunos)

Figure 6. Lames d’eau mesurées en 24 heures le 3 octobre 2016 en PACA (Source : Keraunos)

Ces deux approches s’appliquent généralement à des situations différentes (les régressions environnementales en cas de relief contrasté, par exemple), mais peuvent se combiner à certaines étapes du calcul : les résidus (écart entre valeur observée en un point et valeur recalculée par le modèle) d’une régression environnementale peuvent être soumis au krigeage, s’ils ont une structure spatiale.

A ces démarches empiriques, on peut opposer une autre approche, déductive, totalement différente, celle de la modélisation déterministe fondée sur les lois de la physique. Ici, pour reconstituer un champ d’une variable (températures, précipitations…), on n’utilise pas un jeu de données locales (mesures), mais les lois physiques qui gouvernent une variable en calculant celle-ci à chaque point d’une grille (ou chaque pixel) à partir de la densité de l’air, du bilan radiatif, de la conduction dans le sol, de l’advection (apport d’air) horizontale et verticale, de la chaleur latente libérée par la condensation ou consommée par l’évaporation… Cette logique permet en outre de prévoir à différents horizons temporels, puisqu’en établissant un premier bilan au temps T, appelé « état initial », il est possible de calculer un nouvel état à court, moyen ou long terme qui devient à son tour un nouvel état initial et ainsi de suite. C’est la base de la prévision météorologique moderne, avec une limite de l’ordre d’une semaine à dix jours pour la prospective à cause du caractère chaotique de l’atmosphère.

3.158.150. Le changement climatique est-il déjà une réalité ?

Les indicateurs d’évolution du climat sont souvent donnés à l’échelle globale, décrivant ainsi une situation générale sur la planète, mais les effets du changement climatique ne sont pas uniformes d’un point de vue spatial et temporel. Selon les continents, les pays, la région ou les territoires, l’évolution du climat diffère, même si les tendances générales concordent.

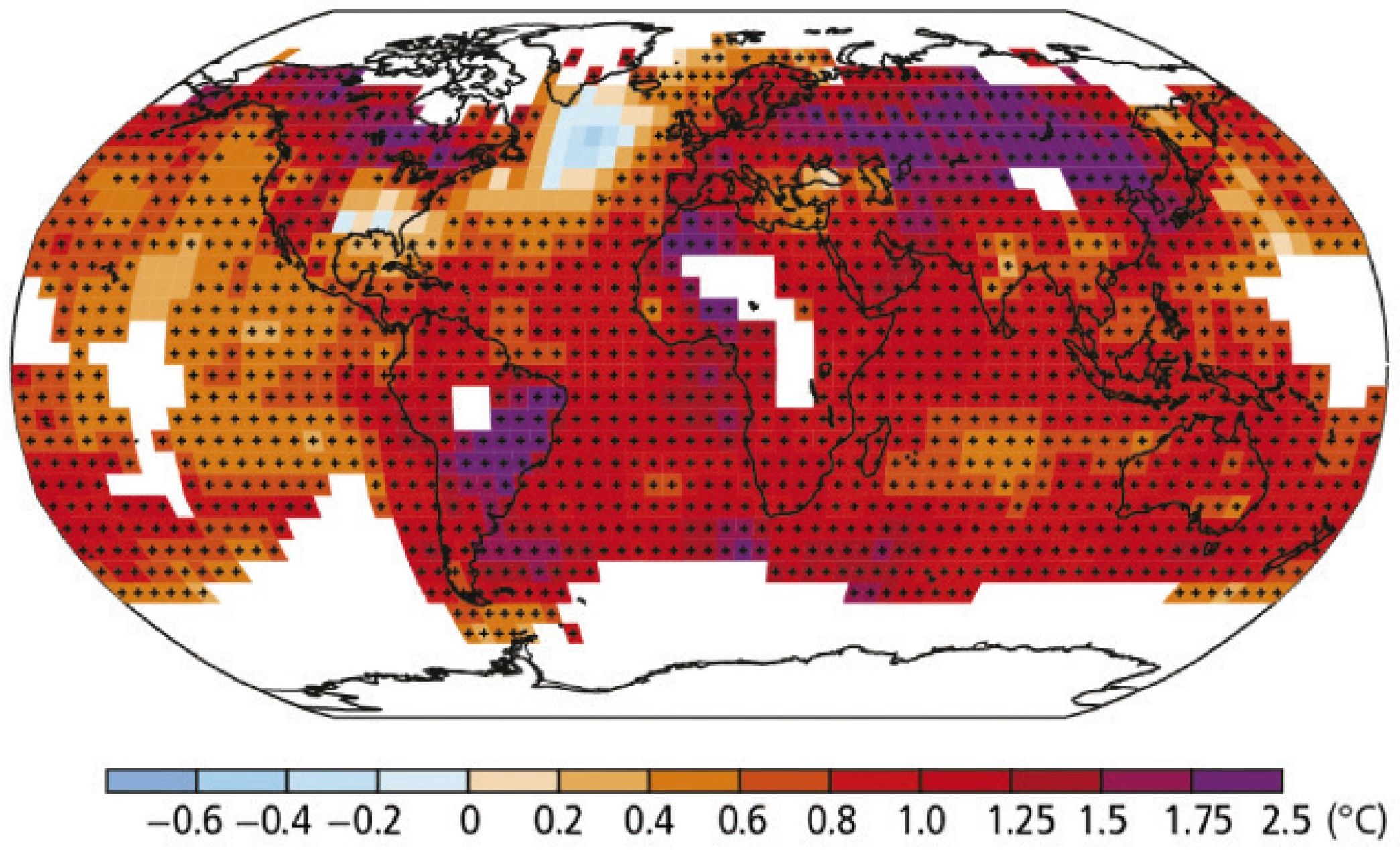

Quelle évolution de la température dans le monde ?

Quand on parle de changement climatique, la première question est de savoir si on observe actuellement ses effets. Le dernier rapport du Groupe d’experts intergouvernemental sur l’évolution du climat (GIEC, WG1, 2013), rassemblant les compilations mondiales des observations depuis le début du 20e siècle, fait un constat clair. Le réchauffement du système climatique est sans équivoque. Depuis les années 1950, les changements observés sont sans précédent depuis des siècles, voire des millénaires. L’atmosphère et l’océan se sont réchauffés, la quantité de neige et de glace a diminué, le niveau des mers s’est élevé, les concentrations de gaz à effet de serre ont augmenté… Chacune des trois dernières décennies a été successivement plus chaude à la surface de la Terre que toutes les décennies antérieures depuis 1850. La période de 1983 à 2012 (30 ans) constitue probablement la période la plus chaude dans l’hémisphère Nord depuis 1400 ans. Depuis cette publication, les années 2014 et 2015 ont battu tous les records. En effet, d’après la National Oceanic and Atmospheric Administration (NOAA), 2015 a été de loin l’année la plus chaude à l’échelle du globe depuis le début des relevés en 1880. Sur l’année, la température moyenne globale — terres et océans compris — a dépassé de 0,9°C la moyenne de référence de 13,9°C calculée sur le 20e siècle. Cette anomalie est supérieure de 0,16°C à celle constatée en 2014, qui était jusqu’ici l’année la plus chaude jamais enregistrée.

La Figure 7 présente la tendance des températures moyennes de surface entre 1901 et 2012 sur le globe. La carte montre que le réchauffement n’est pas uniforme. Il est très sensible sur certaines zones continentales, comme la Russie, la Chine du Nord, le Canada ou encore le Brésil, et au contraire moindre sur les océans. Dans l’Atlantique Nord, au sud du Groenland, une baisse de la température est même constatée. En France, la hausse de la température se situe au niveau de l’augmentation moyenne constatée sur les continents de l’hémisphère Nord.

Quelle évolution de la température en France ?

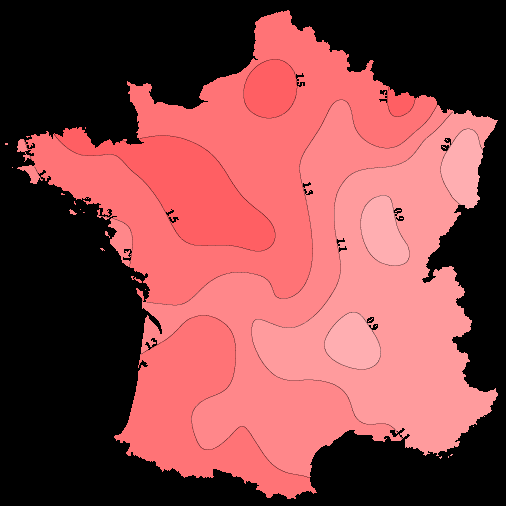

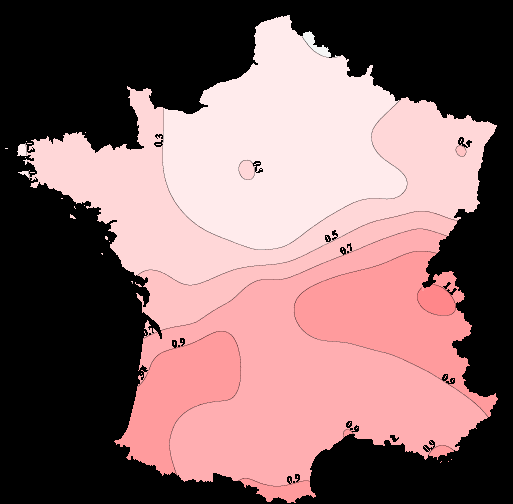

En France métropolitaine, l’évolution des températures moyennes annuelles de l’air montre une tendance au réchauffement (Figure 8). La répartition spatiale de ce réchauffement n’est pas homogène, mais l’augmentation des températures est généralisée sur tout l’Hexagone.

L’augmentation de la température n’est pas la même si l’on considère la température minimale ou maximale de la journée.

Sur la majeure partie du pays, la température en fin de nuit a augmenté plus rapidement que celle relevée en milieu d’après-midi, à l’exception notable des Alpes du Nord.

Le rythme de cette augmentation s’est accéléré de manière significative depuis les années 1980. Ainsi, sur la période 1959- 2009, la tendance observée est d’environ +0,3°C par décennie et les trois années les plus chaudes (2014, 2011 et 2015) ont été observées dans les cinq dernières années. A l’échelle de la France, la température moyenne a dépassé la normale 1981- 2010 de 1,2°C en 2014, de 1,1°C en 2011 et de 0,9°C en 2015.

Figure 8. Tendances annuelles 1900-2000 des températures de l’air (minimales à gauche, maximales à droite). Source : Météo-France

ZOOM 4. Reconnaître les tendances climatiques

Comment détecter les tendances climatiques ?

La détection des tendances climatiques fait appel à des techniques statistiques sophistiquées. En effet, pour apprécier une tendance du climat à long terme dans une série de données, il faut tout d’abord disposer de plusieurs dizaines d’années de mesures, car la variabilité interannuelle des données, c’est-à-dire l’ordre de grandeur des différences de valeur d’une année à l’autre, est plus forte que le signal climatique que l’on cherche à détecter. Mais plus la série de données est longue, plus elle est susceptible d’avoir été perturbée par d’autres facteurs : changement du capteur de mesures ou de sa localisation, modifications de l’environnement local ou de la méthodologie de mesure… Il convient donc de vérifier, en comparant les mesures réalisées à un poste à celles effectuées à des postes voisins, si des discontinuités existent dans la série de mesures. Si c’est le cas, on effectue une correction statistique de la série et on crée ainsi une série « homogénéisée », débarrassée des ruptures détectées et dont l’évolution ne représente plus que le signal du changement climatique. Météo-France a ainsi homogénéisé 230 séries de

températures et 1100 séries de précipitations en France métropolitaine. Ce jeu de données permet de poser un diagnostic précis sur les tendances observées depuis le milieu du 20e

siècle.

La variabilité climatique en question

Détecter une tendance sur un paramètre climatique présentant une variabilité importante n’est pas facile. L’évolution de fond est en effet masquée par les écarts d’une année à l’autre. Pour être plus explicite, faisons le parallèle avec les vagues déferlant sur une plage : la première vague

vient mourir à un certain niveau sur la plage, la suivante un peu moins haut, une autre beaucoup plus bas, puis la nouvelle dépasse les trois premières, et ainsi de suite. Si on observe dix vagues successives, on est incapable de dire si la marée monte ou descend. Au bout de cinq cents vagues, même si les vagues continuent de déferler de manière différente, le sens de la marée se dessine sans le moindre doute. Pour le climat, la logique est similaire. Et même si cela peut paraître paradoxal, il est plus difficile, en théorie, de déterminer le climat de la prochaine décennie que celui de la fin du siècle.

Ces tendances (Zoom 4) montrent que le changement climatique a débuté depuis les années 80 en France, notamment en ce qui concerne les températures. De plus, les années 2014 et 2015 sont les années les plus chaudes observées depuis les relevés disponibles. La tendance au réchauffement est perceptible et le changement climatique est une réalité à laquelle nous devons faire face en PACA.

Le signal du changement climatique est-il déjà observé en PACA ?

Pour témoigner de l’évolution récente du climat présent en Provence-Alpes-Côte d’Azur, des indicateurs relatifs à la température de l’air, aux précipitations et au vent sont commentés.

Températures de l’air

Les séries homogénéisées de températures en Provence-Alpes-Côte d’Azur (23 séries sur les températures minimales et 28 séries sur les températures maximales) permettent d’évaluer de façon précise les tendances au cours des cinquante dernières années.

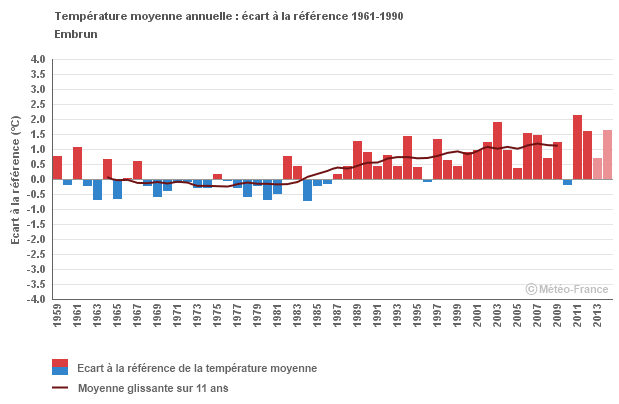

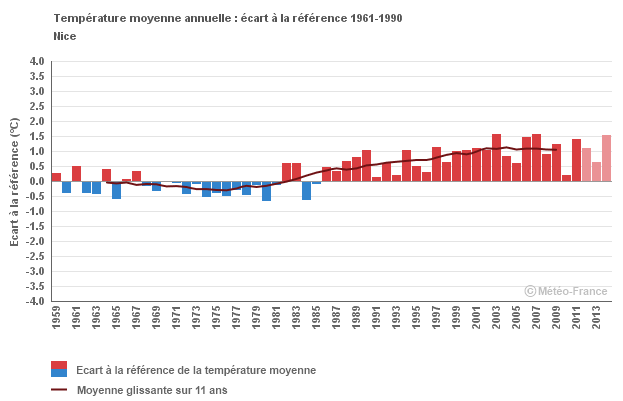

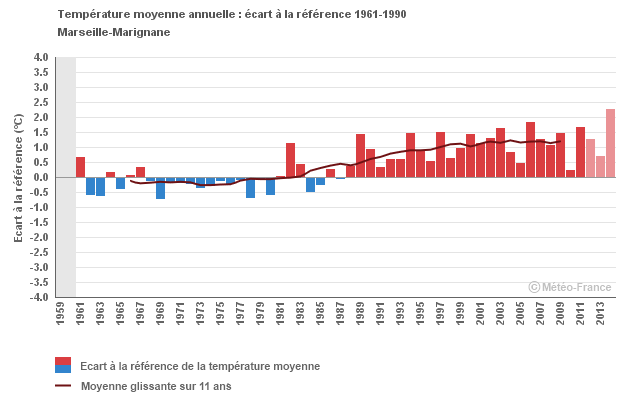

La Figure 9 illustre l’évolution annuelle de l’écart de la température moyenne à la normale 1961-1990 (moyenne des températures moyennes sur la période de 30 ans) pour trois stations représentatives de la région.

Ces diagrammes montrent que la température moyenne annuelle est globalement en augmentation, même si une forte variabilité d’une année à l’autre est constatée. Pourtant, l’augmentation n’est pas uniformément répartie sur l’année. Certaines saisons ont une hausse moindre :

- la tendance observée des températures moyennes hivernales est de l’ordre de +0,2°C par décennie ;

- la saison d’été est celle qui présente le réchauffement le plus fort sur les cinquante dernières années. Sur la période 1959-2009, la tendance observée des températures moyennes estivales est d’environ +0,5°C par décennie. Les trois étés les plus frais depuis 1959 ont été observés avant les années 1980. Les plus chauds se sont produits après l’année 2000. Le caractère hors-norme de l’été 2003 est bien visible.

La hausse globale observée sur les températures en PACA a des répercussions sur le nombre de jours de gel et le nombre de journées chaudes :

- le nombre annuel de jours de gel est très variable d’une année à l’autre, mais aussi selon les territoires : les gelées sont rares sur le littoral et plus fréquentes à l’intérieur des terres. En cohérence avec l’augmentation des températures moyennes, le nombre annuel de jours de gel est plutôt en diminution, mais celui-ci varie fortement d’un point de mesure à l’autre. Les années 2014 et 2015 sont parmi les moins gélives en PACA. A Cannes, le nombre de jours de gel moyen par année est de 14. Il a gelé 3 jours en 2014 et 4 jours en 2015. A Saint-Auban-sur-Durance, au lieu de 59 jours de gel en moyenne, on en a observé seulement 27 en 2014 et 38 en 2015 ;

- le nombre annuel de journées chaudes (températures maximales supérieures à 25°C) est également très variable d’une année à l’autre et selon la localisation géographique : les journées chaudes sont plus fréquentes lorsqu’on s’éloigne du relief et de la mer Méditerranée. Sur la période 1959-2009, on observe une augmentation forte du nombre de journées chaudes, entre 6 à 7 jours par décennie. 2003, 2009 et 2011 sont les années qui ont connu le plus grand nombre de journées chaudes.

A l’instar du niveau national, la température minimale en PACA augmente plus vite que la température maximale.

Figure 9. Ecart des températures moyennes annuelles par rapport à la référence 1961-1990 (Météo-France/ClimatHD, www.meteofrance.fr/climat-passe-et-futur/climathd)

Précipitations

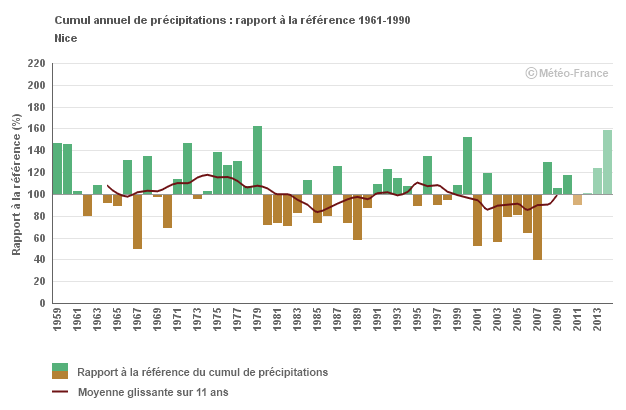

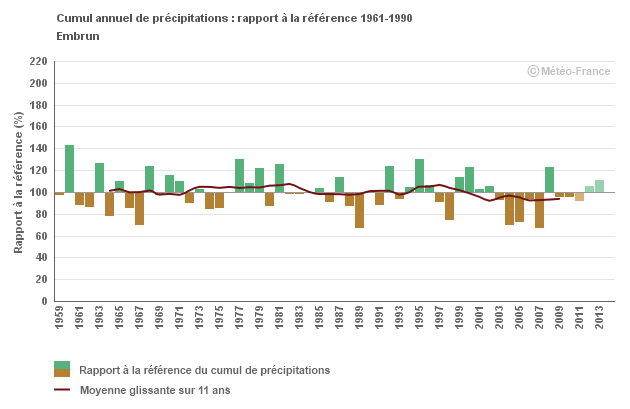

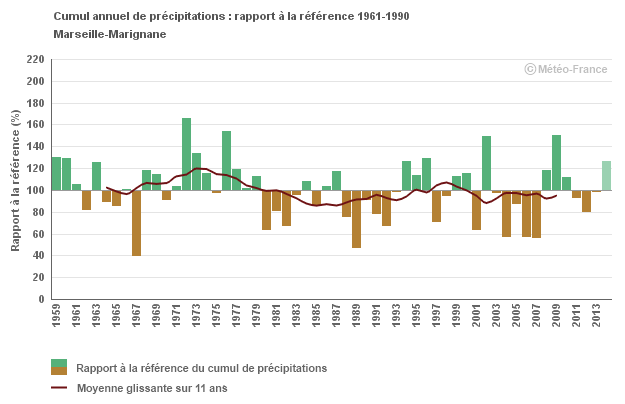

Les précipitations annuelles présentent une grande variabilité interannuelle comme le montrent les diagrammes de la Figure 10 qui représentent les anomalies des cumuls annuels de 1959 à 2014 par rapport à la moyenne des précipitations sur 30 ans (1961-1990). Ainsi, une année positive (en vert) sera plus pluvieuse que la normale, alors qu’une année négative (en marron) sera plus sèche que la normale.

Figure 10. Anomalies des cumuls annuels de précipitations par rapport à la moyenne des précipitations sur 30 ans (période de référence : 1961-1990). La courbe représente la moyenne glissante des cumuls annuels sur 11 ans (Météo-France/ClimatHD)

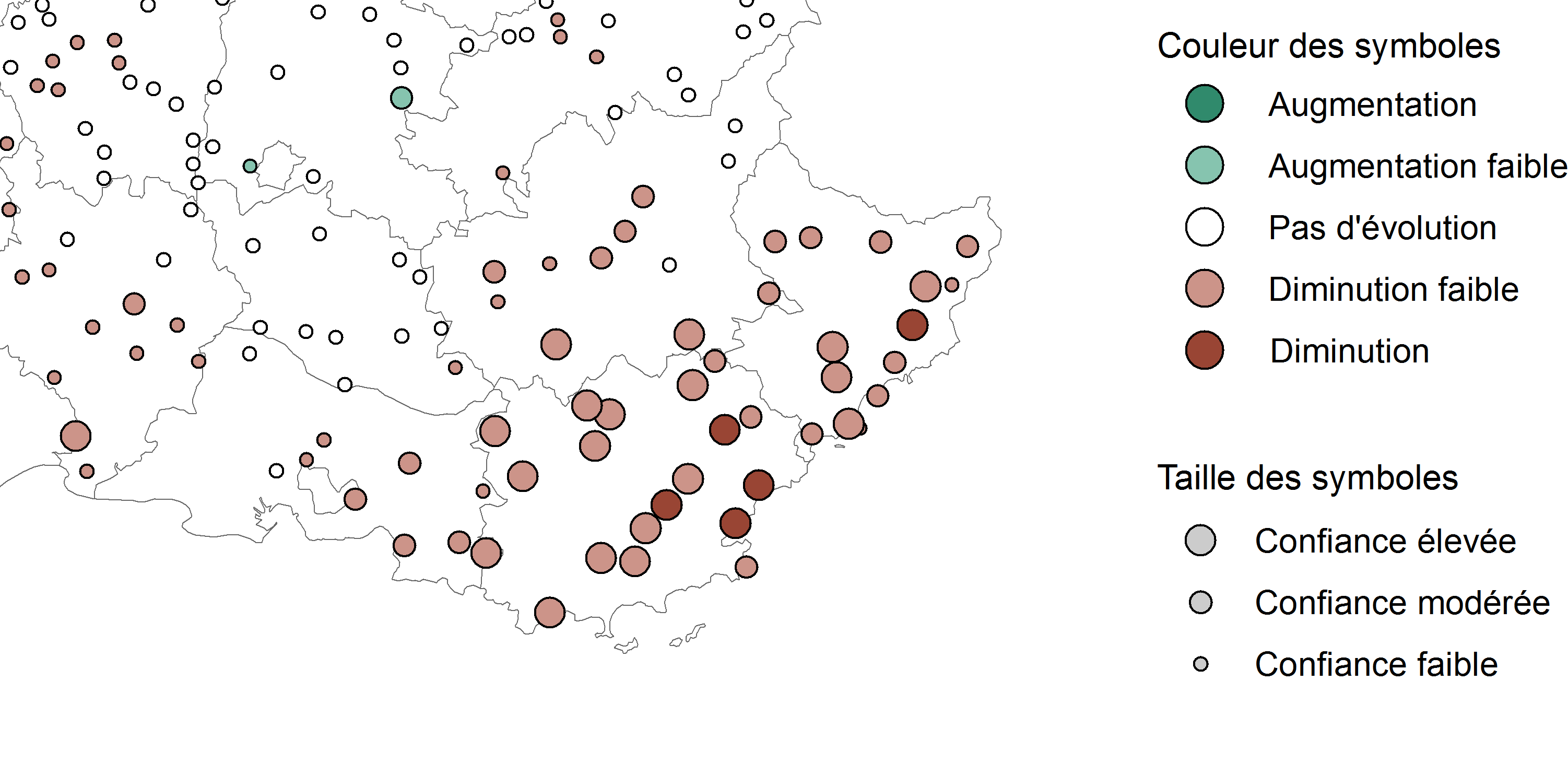

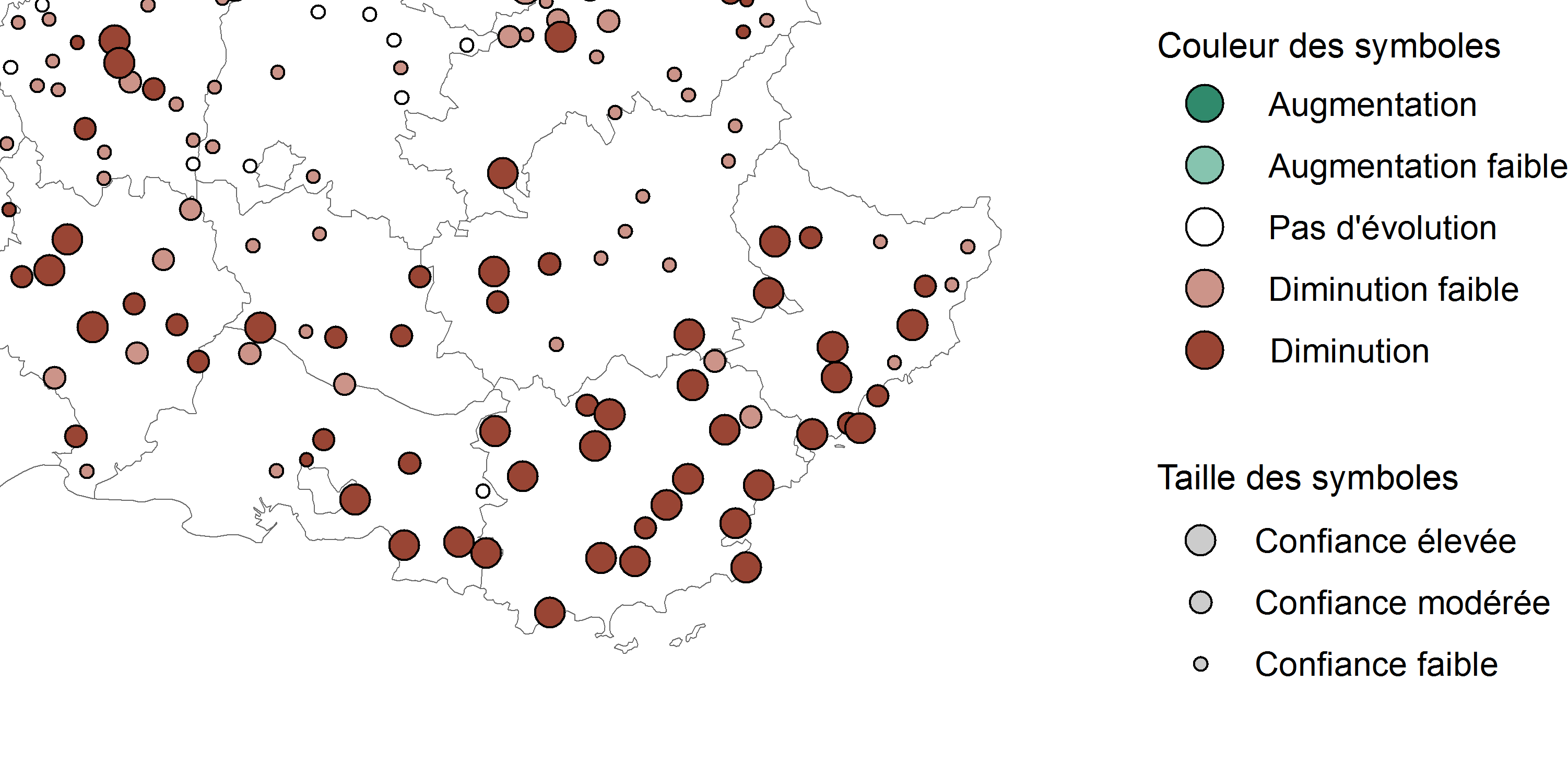

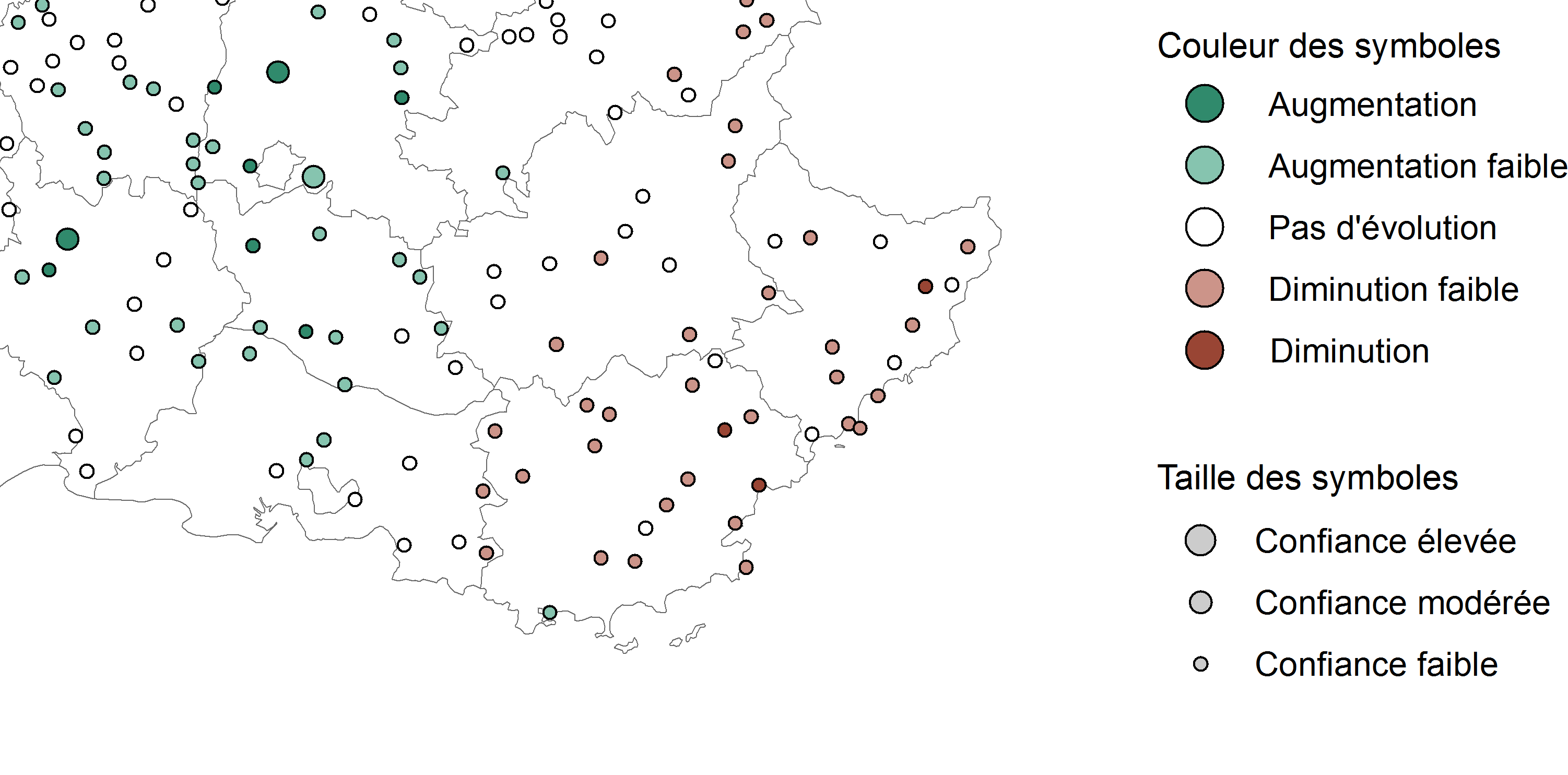

Les Figures 11 et 12 présentent la répartition spatiale des tendances des cumuls annuels ou saisonniers de précipitations. Sur ces cartes, les pastilles sont en vert lorsque la tendance montre une augmentation des précipitations, en rouge lorsque la tendance montre une diminution. La taille du symbole représente le niveau de confiance de la tendance estimée, basé sur un test statistique.

Sur la période 1959-2009, les tendances sont très peu marquées sur l’ouest et le nord de la région. Sur le Var et les Alpes-Maritimes, il existe un signal plus cohérent avec une diminution faible des cumuls annuels, mais ce signal n’est pas toujours statistiquement significatif.

Comme pour les températures de l’air, de forts écarts sont constatés selon les saisons. La baisse est plus importante et significative en hiver et en été, mais le signal est beaucoup plus faible au printemps et surtout à l’automne. En hiver et pour la majeure partie du Var et de l’ouest des Alpes-Maritimes, la diminution des pluies est à la fois plus importante (en pourcentage) et plus significative statistiquement que pour l’année entière (Figure 12). A contrario, en automne, le signal vers une diminution ou une augmentation n’est pas univoque et aucune des tendances calculées n’est robuste au sens statistique.

Figure 12. Evolution relative des cumuls de précipitations en hiver (en haut) et en automne (en bas) par point de mesure en PACA et départements limitrophes (source : Météo-France/ClimatHD, http://www.meteofrance.fr/climat-passe-et-futur/climathd)

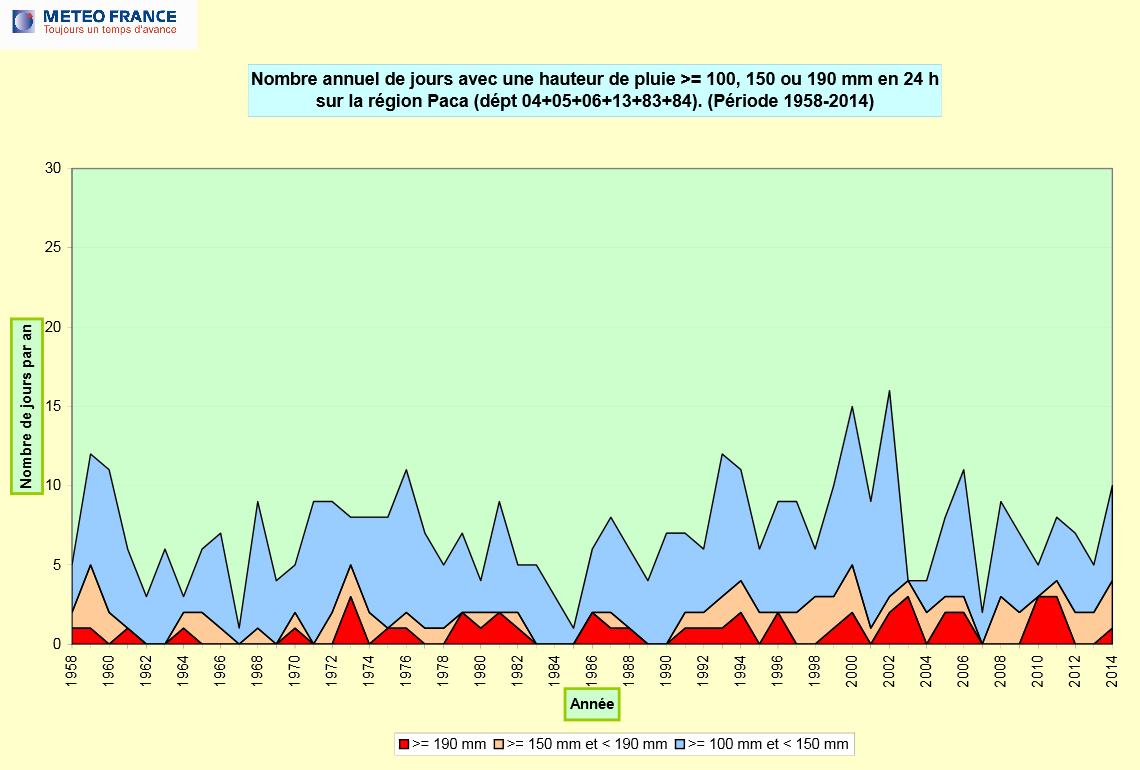

En région PACA, l’analyse de la fréquence des événements pluvieux intenses méditerranéens (seuils journaliers de 100, 150 ou 190 mm) depuis 1958 ne met pas en évidence de tendance d’évolution du nombre d’épisodes (Figure 13). La principale caractéristique des événements extrêmes reste la forte variabilité interannuelle. Ainsi, en région PACA, selon les années, on peut enregistrer 1 à 16 journées avec des pluies supérieures ou égales à 100 mm, 0 à 5 journées supérieures ou égales à 150 mm et 0 à 3 journées supérieures ou égales 190 mm.

Figure 13. Nombre annuel de jours de précipitations intenses en 24 heures dans les départements de la région Provence-Alpes-Côte d’Azur (source : Météo-France)

Figure 13. Nombre annuel de jours de précipitations intenses en 24 heures dans les départements de la région Provence-Alpes-Côte d’Azur (source : Météo-France)

Force du vent

Les tendances sur le vent sont plus difficiles à apprécier, d’une part, parce que ce paramètre n’a pas été homogénéisé et ensuite du fait d’un changement global de la méthode de mesure du vent par Météo France dans les années 1990. Cette modification a introduit une rupture dans les séries de mesures et rend difficilement comparables les valeurs avant et après ce changement.

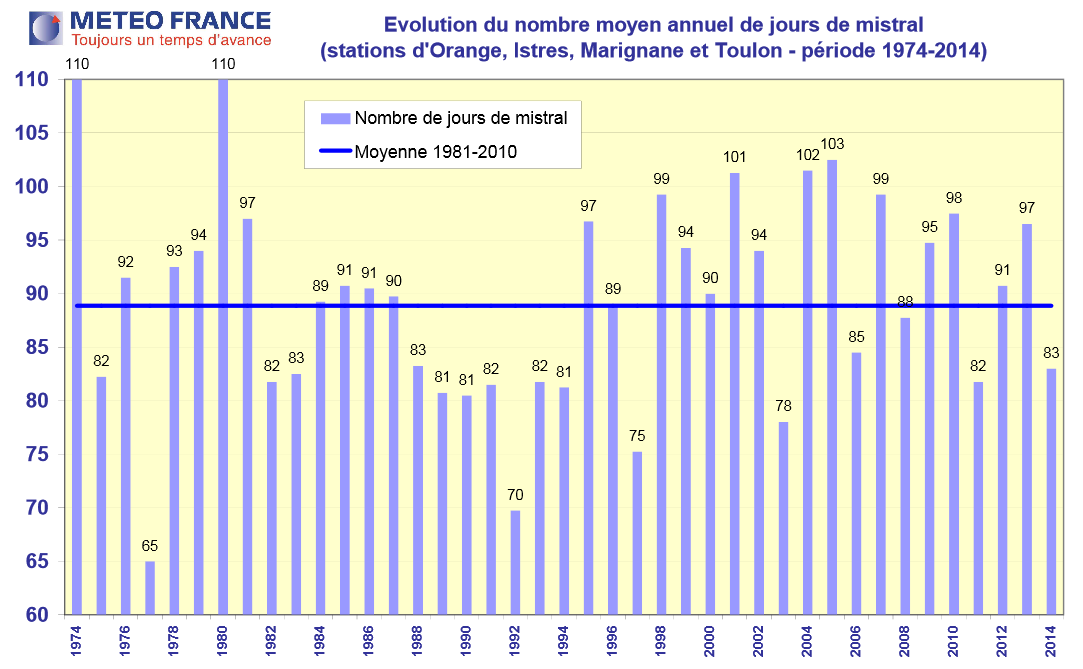

Une analyse de la fréquence des vents forts est néanmoins possible. La Figure 14 montre l’évolution du nombre moyen annuel de jours de Mistral (vent de secteur nord-ouest supérieur à 10 mètres/seconde) mesuré par quatre

stations de la région. Cette évolution de la fréquence des vents forts n’est pas significative sur la période 1974-2014. En moyenne, par an, depuis le déploiement des nouveaux capteurs, on enregistre 90 jours de vent fort (plus ou moins 15%).

Figure 14. Evolution du nombre moyen annuel de jours de Mistral (supérieur à 10 mètres/seconde) à Orange, Istres, Marignane et Toulon (source : Météo-France)

Figure 14. Evolution du nombre moyen annuel de jours de Mistral (supérieur à 10 mètres/seconde) à Orange, Istres, Marignane et Toulon (source : Météo-France)

3.200. Résultats de données spatialisées à l’échelle locale et régionale

La température de l’air est une variable physique qui se répartit de manière non homogène dans l’espace et parfois des modifications de plusieurs degrés sont constatées sur de très courtes distances (quelques mètres). De multiples facteurs influencent localement l’évolution des températures comme, entre autres, la couleur de la surface du sol, la nature des matériaux, la présence de végétation ou encore l’exposition au rayonnement solaire. Ainsi, la température donnée par la « météo » à la télévision ou sur internet pour une ville ne reflète absolument pas les disparités spatiales locales. Il s’agit uniquement de la température mesurée ou attendue dans la station météorologique la plus proche de la ville en question, et donc d’une donnée ponctuelle dans l’espace. Cette notion de variabilité spatiale des températures aux échelles régionales et locales à travers la mesure, la cartographie et la modélisation (géostatistique et déterministe) est importante à comprendre.

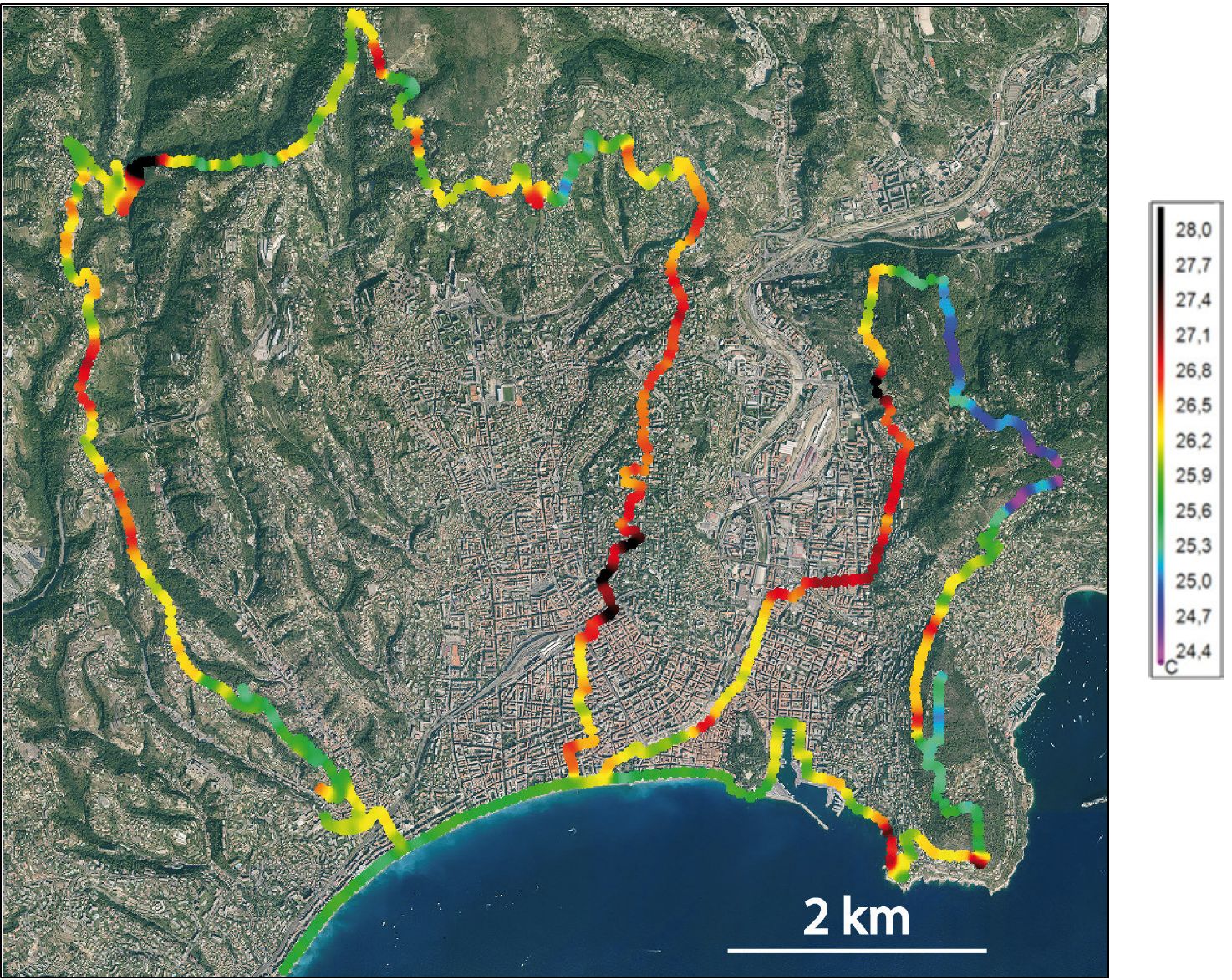

La meilleure manière de vérifier les variations de températures dans l’espace est de se déplacer avec un thermomètre et d’enregistrer les localisations successives ainsi que les valeurs de températures correspondantes. Ces mesures, qualifiées d’itinérantes, ont été, par exemple, réalisées au cours de 54 journées de mai à septembre 2015 à Nice sur le même parcours de 50 km en milieu d’après-midi (Figure 15). Elles ont permis de constater des variations moyennes de plus de 2 à 3°C en fonction du lieu de mesure. La proximité de la mer, de la végétation, mais aussi du bâti influence fortement la température. L’espace le plus urbanisé ressort légèrement plus chaud que le reste du parcours : ce phénomène est appelé « îlot de chaleur urbain (ICU) » (Zoom 5) et il s’observe très fréquemment à travers le monde dans de très nombreuses villes.

Les températures sont plus élevées en milieu urbanisé car, pendant la journée, les concentrations denses de bâtiments et de matériaux, comme l’asphalte, absorbent plus de chaleur et la libèrent plus lentement la nuit que la couverture naturelle du sol, telle que la végétation.

Figure 15. Cartographie des températures moyennes en milieu d’après-midi à Nice au cours de 54 jours de mesures entre mai et septembre 2015 (source : Nicolas Martin, UMR ESPACE)

Figure 15. Cartographie des températures moyennes en milieu d’après-midi à Nice au cours de 54 jours de mesures entre mai et septembre 2015 (source : Nicolas Martin, UMR ESPACE)

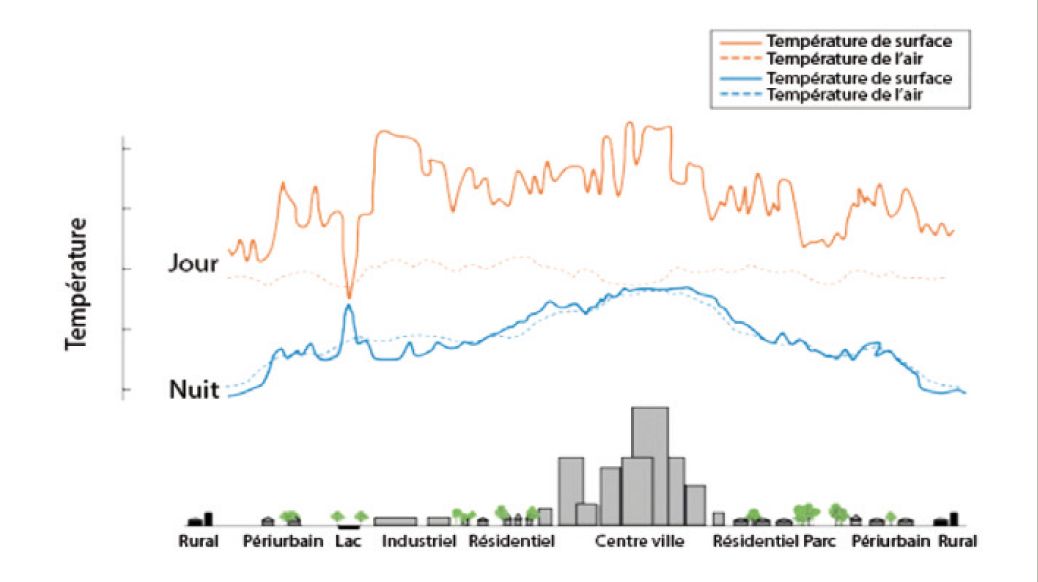

ZOOM 5. Qu’est-ce que l’îlot de chaleur urbain ?

On appelle « îlot de chaleur urbain » (ICU) la différence des températures observées entre un site urbain et un site rural environnant. Ces différences de températures, davantage marquées la nuit, sont fortement corrélées à la variation de la densité urbaine (conception urbaine, matériaux des bâtiments, etc.).

Les ICU sont principalement observés la nuit (Figure 16) où le refroidissement nocturne est moindre en ville que dans les zones rurales plus végétalisées. C’est un phénomène local qui peut varier d’une rue à l’autre avec une durée limitée dans le temps. Les principaux facteurs météorologiques qui favorisent l’îlot de chaleur urbain sont : un ciel peu nuageux, des vents faibles et une forte stabilité atmosphérique.

Dans les villes des latitudes moyennes, l’îlot de chaleur urbain peut être plus important lors des nuits estivales, quand la chaleur emmagasinée par les bâtiments pendant le jour est dissipée. Les impacts de ces « bulles

de chaleur » peuvent être importants sur le confort thermique, la santé, la mortalité et les risques de pollution. Dans un contexte de changement climatique, les canicules estivales pourraient être plus fréquentes d’où l’importance de mieux comprendre la variabilité spatiale et temporelle de ce phénomène dans les villes méditerranéennes, et de tenter de le réduire. De nouveaux défis face au changement climatique supposent de nouveaux modes de gestion pour la ville et appellent à s’appuyer :

- d’une part, sur des données fiables à échelle fine, aussi bien pour le suivi du climat que celui des impacts, indispensables pour disposer d’un outil adapté à la complexité urbaine et à ses spécificités ;

- d’autre part, sur le diagnostic des usages contemporains des villes méditerranéennes, afin de concevoir des espaces urbains dont la rationalité énergétique et fonctionnelle sera basée sur les pratiques et les besoins des citadins, mais aussi sur une approche interdisciplinaire capable de prendre en compte la complexité des villes contemporaines à travers une coaction entre les scientifiques et les politiques.

Figure 16. Températures de surface de l’atmosphère variant en fonction des types d’occupation du sol (source : illustration adaptée de Environnemental Protection Agency)

Figure 16. Températures de surface de l’atmosphère variant en fonction des types d’occupation du sol (source : illustration adaptée de Environnemental Protection Agency)

En complément de la mesure, la géostatistique permet, à l’aide de méthodes rigoureuses, de calculer les températures sur un territoire donné en prenant en compte ses spécificités. A partir de données ponctuelles (mesures) ou surfaciques à basse résolution spatiale (modélisation), et de variables géographiques (altitude, distance à la mer, rugosité topographique…), la régression environnementale offre la possibilité d’étendre l’information à l’ensemble d’un département ou d’une région à une résolution spatiale suffisamment fine pour apprécier la différenciation des températures sur de courtes distances. Cette étape de spatialisation se nourrit soit de l’observation directe du climat réalisée par un réseau de stations météorologiques, soit de résultats de simulations climatiques calculés par des logiciels informatiques modélisant le système climatique terrestre.

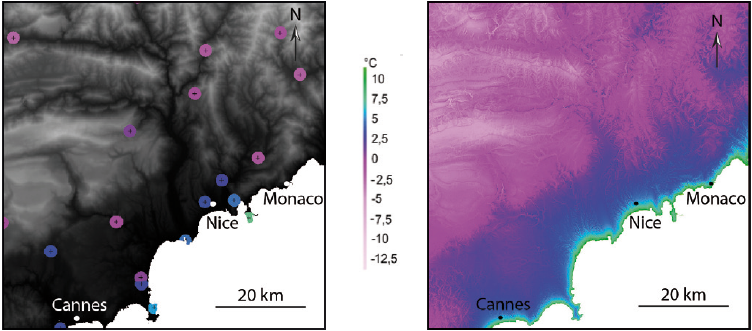

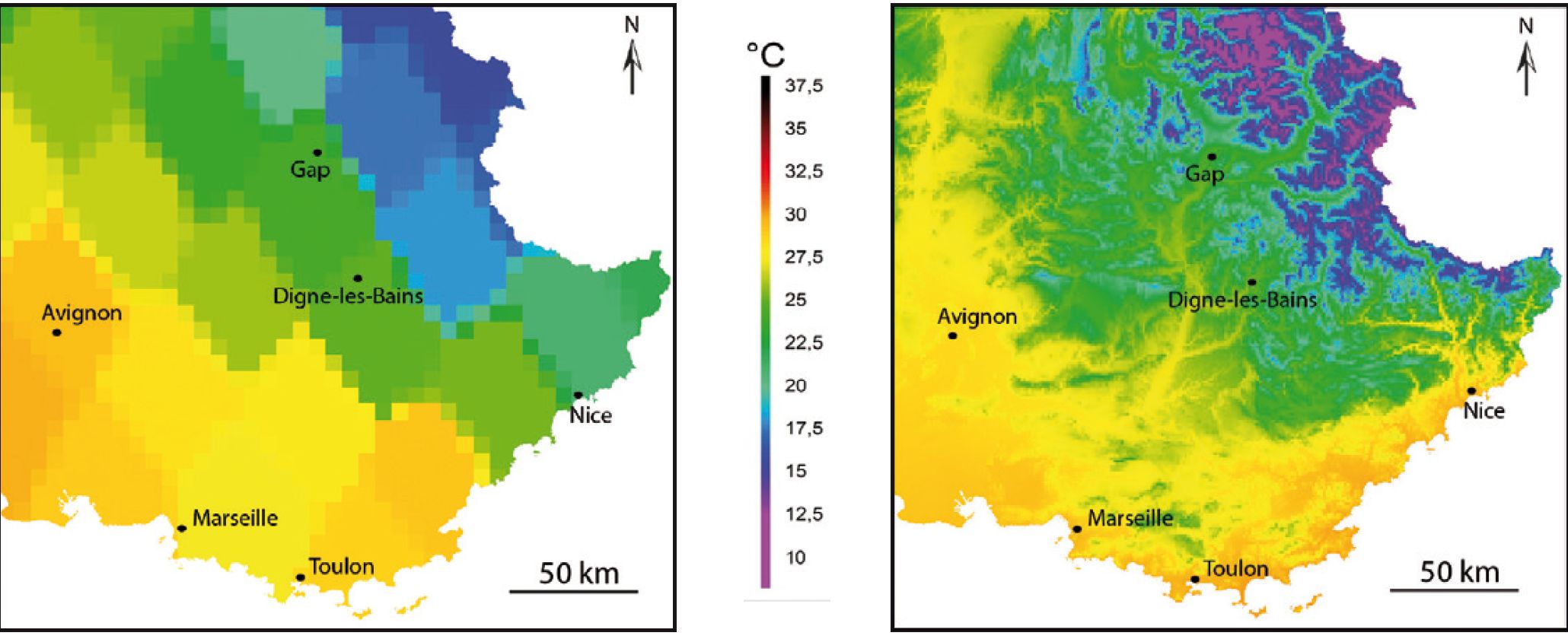

Pour illustrer ces propos, trois exemples de spatialisation des normales de températures maximales de juillet et des normales de températures minimales de janvier, pour les périodes 1961-1990 ou 1988-2013, sont présentés (Figure 17, Figure 18, Figure 19). Le premier exemple s’appuie sur l’observation du climat dans les Alpes-Maritimes et les deux suivants sur sa modélisation déterministe à diverses résolutions spatiales.

Figure 17. Cartographie des températures minimales de janvier pour la période 1988-2013 mesurées par le

réseau de stations de Météo-France dans la moitié sud des Alpes-Maritimes (à gauche : en fond, altitude en

niveaux de gris) et spatialisation à 25 m de résolution spatiale de ces mêmes températures par régression

environnementale (à droite). Source : Nicolas Martin, UMR ESPACE

Figure 17. Cartographie des températures minimales de janvier pour la période 1988-2013 mesurées par le

réseau de stations de Météo-France dans la moitié sud des Alpes-Maritimes (à gauche : en fond, altitude en

niveaux de gris) et spatialisation à 25 m de résolution spatiale de ces mêmes températures par régression

environnementale (à droite). Source : Nicolas Martin, UMR ESPACE

Le réseau météorologique de stations de Météo-France des Alpes-Maritimes enregistre quotidiennement les températures de l’air. Ces données sont ensuite vérifiées et agglomérées pour aboutir à des moyennes mensuelles établies sur 20 ou 30 ans. On parle alors de normales climatiques. La représentation cartographique de ces valeurs ponctuelles sur la période 1988-2013 n’est pas très informative (Figure 17) puisque chaque mesure locale représente un point et non un espace ou une surface. Cependant, chaque station météorologique est caractérisable par un ensemble de propriétés géographiques et environnementales permettant d’établir une équation de régression multiple liant les normales de températures relevées aux différents critères « physiques ». L’équation, une fois validée, est alors étendue à l’ensemble des « vides spatiaux » pour produire une cartographie à 25 m de résolution spatiale.

La logique suivie pour l’amélioration de la résolution spatiale des sorties de modèles climatiques est la même. Comme pour une station météorologique, il est possible de déterminer, pour chaque maille ou pixel de 50 km de côté du modèle ARPEGE-Climat, une moyenne pour chacune des propriétés géographiques et environnementales. Puis une équation de régression multiple établit le lien entre la température modélisée et les critères physiques de chaque pixel. Ces équations statistiques sont alors appliquées à une grille de 1 km de résolution spatiale. Ainsi, à partir d’une température moyenne recouvrant 2500 km2 (pixels de 50 x 50 km), ce sont 2500 nouvelles températures (Figure 18) qui ont été calculées (nouveaux pixels de 1 x 1 km).

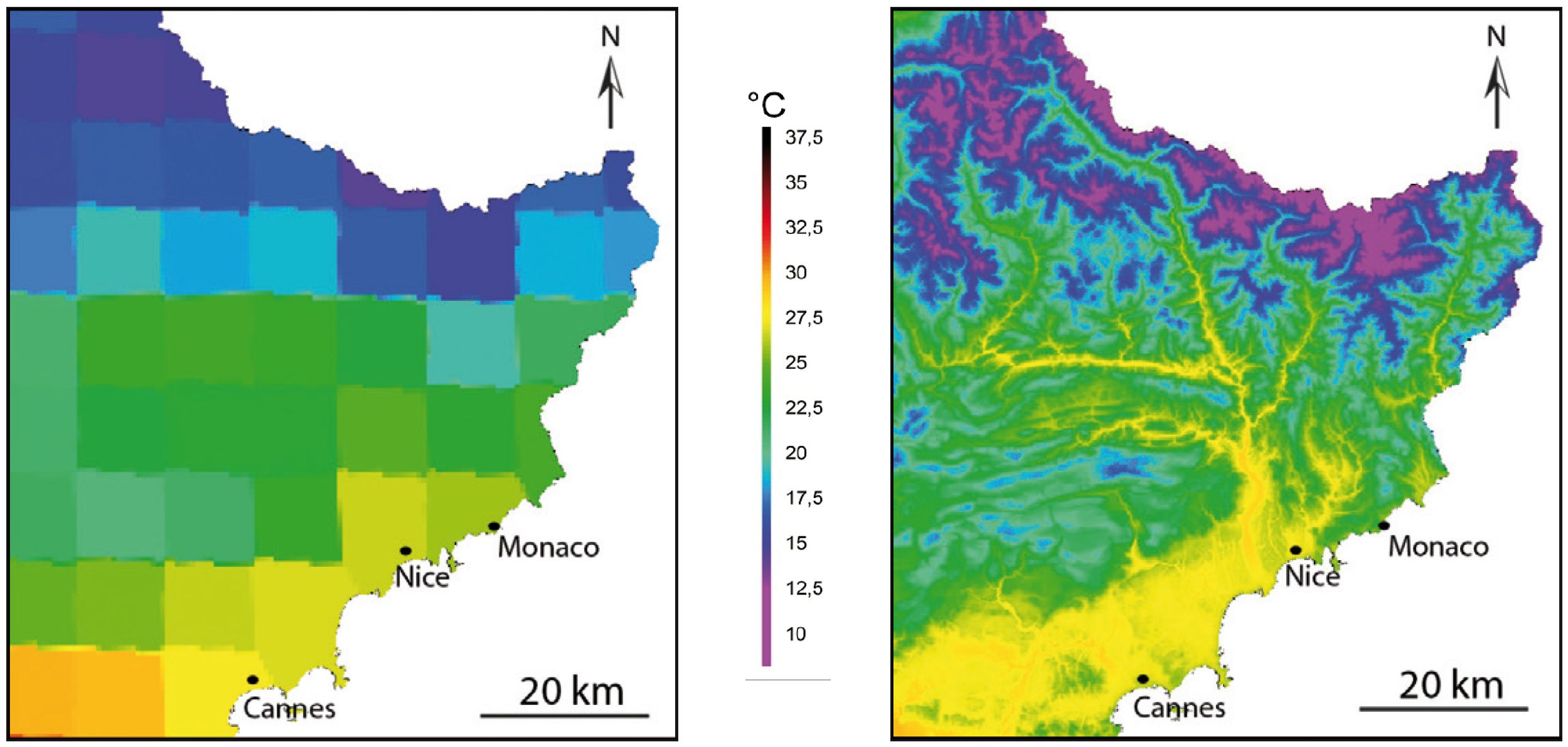

A l’échelle départementale, l’amélioration de la résolution spatiale des modèles climatiques est encore plus poussée avec un saut de 12 km à 90 m, ce qui signifie que près de 17 800 nouvelles températures ont été simulées à partir d’une unique valeur disponible sur les pixels initiaux de 144 km2 du modèle ALADIN-Climat (Figure 19).

Figure 18. Cartographie des températures maximales de juillet pour la période 1961-1990 simulées par le modèle ARPEGEClimat en région PACA (pixels de 50 km de côté, à gauche) et spatialisation à 1 km de résolution spatiale de ces mêmes températures par régression environnementale (à droite). Source : Nicolas Martin, UMR ESPACE

Figure 18. Cartographie des températures maximales de juillet pour la période 1961-1990 simulées par le modèle ARPEGEClimat en région PACA (pixels de 50 km de côté, à gauche) et spatialisation à 1 km de résolution spatiale de ces mêmes températures par régression environnementale (à droite). Source : Nicolas Martin, UMR ESPACE

Figure 19. Cartographie des températures maximales de juillet pour la période 1961-1990 simulées par le modèle ALADINClimat dans les Alpes-Maritimes (pixels de 12 km de côté, à gauche) et spatialisation à 90 m de résolution spatiale de ces mêmes températures par régression environnementale (à droite). Source : Nicolas Martin, UMR ESPACE

Figure 19. Cartographie des températures maximales de juillet pour la période 1961-1990 simulées par le modèle ALADINClimat dans les Alpes-Maritimes (pixels de 12 km de côté, à gauche) et spatialisation à 90 m de résolution spatiale de ces mêmes températures par régression environnementale (à droite). Source : Nicolas Martin, UMR ESPACE

Enfin, en plus de la cartographie dite « géostatistique » présentée précédemment, il existe également des modèles météorologiques ou climatiques régionaux « déterministes » ou « mécanistes » qui ont été développés pour simuler à fine échelle spatiale les phénomènes à méso-échelle, comme les écoulements locaux, la convection, l’effet topographique ou les ondes de gravité. Ces phénomènes se produisent sur des étendues inférieures à 50 km dans la couche limite atmosphérique (zone comprise entre la surface et environ 1500 m d’altitude, hors relief) et sont résolus par un ensemble de schémas physiques et une paramétrisation qui assure les interactions entre chaque module utilisé.

Pour simuler la température de surface, plusieurs aspects doivent être pris en compte : l’impact du sol et de l’occupation du sol, soit le transfert de chaleur entre le sol et l’atmosphère. Ce compartiment est pris en compte par un modèle sol qui calcule les transferts de chaleur et d’humidité entre le sol, la végétation et l’atmosphère. Cela repose donc sur les flux moléculaires et les effets de turbulence dans les premiers mètres de l’atmosphère. Cette turbulence atmosphérique n’est pas résolue directement par les équations, car elle se manifeste à une résolution inférieure à la grille du modèle. Une méthode de paramétrisation qui consiste à relier certaines quantités (température, humidité) avec des paramètres connus est mise en oeuvre. Pour cela, on applique la méthode de « fermeture » dans les équations. La fermeture locale consiste, en un point de grille, à remplacer les quantités inconnues par des valeurs ou des gradients de valeurs connues. Dans le cas de la fermeture non locale, cette technique est appliquée à plusieurs points de grille. Il est alors possible de calculer les flux d’humidité et de chaleur dans la couche limite et leur diffusion verticale. Ce schéma interagit ensuite avec le rayonnement atmosphérique qui calcule l’apport énergétique au sol.

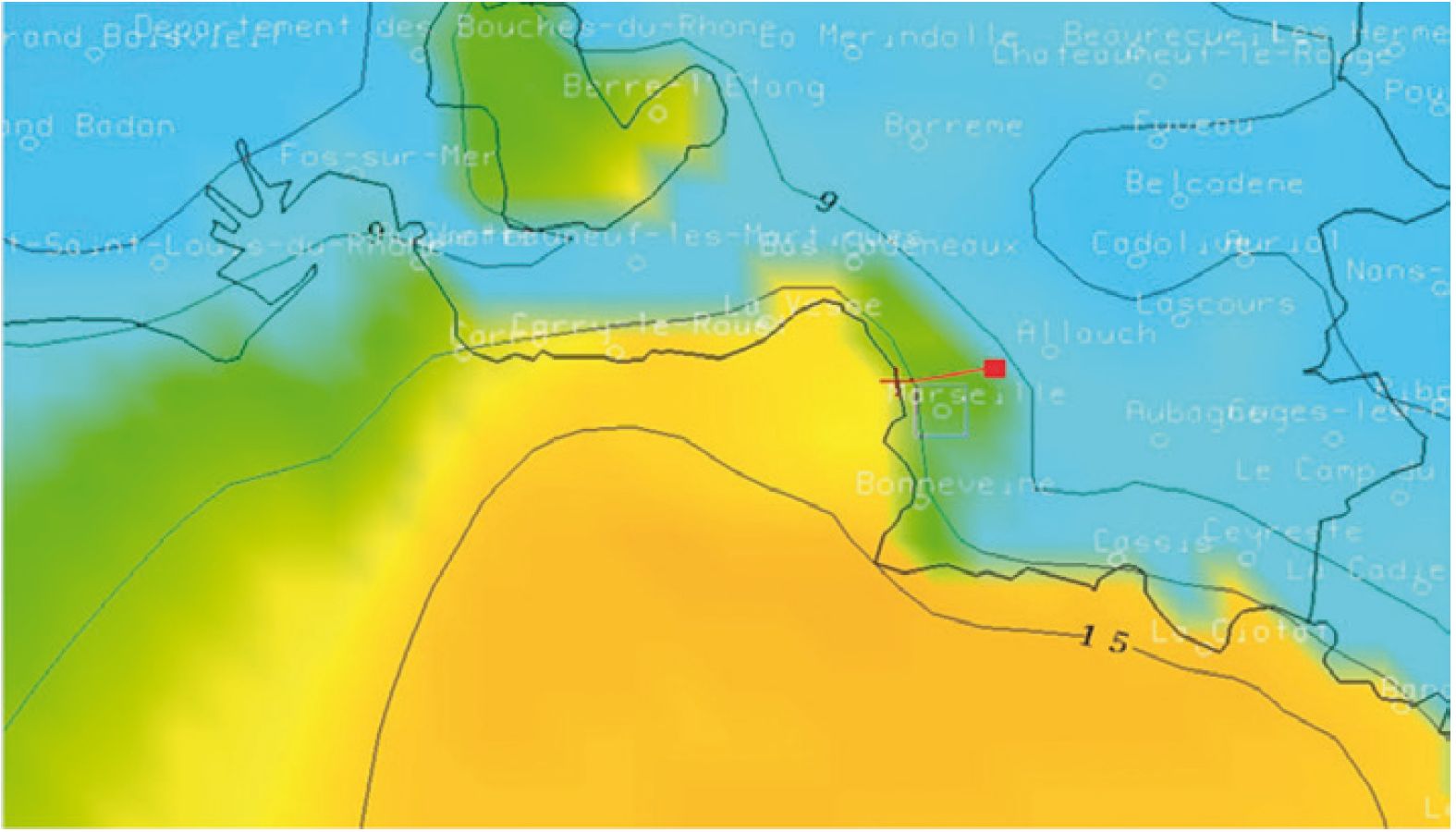

A titre d’exemple, les températures à 2 m (au-dessus du sol), modélisées sur une partie du département des Bouches-du-Rhône le jeudi 12 décembre 2015 à 7h TU, sont illustrées dans la Figure 20. Cette sortie de modèle montre la répartition des températures à 2 m par une approche déterministe. Le modèle représente l’effet urbain de la ville de Marseille représenté par une couleur verte, puis un refroidissement plus net sur les premiers reliefs marseillais. Sur les 5,7 km de l’axe rouge, séparant le littoral des premiers reliefs, le gradient est de 5°C. Ce dernier devient plus fort sur l’est de la ville dans le secteur des calanques, avec une zone froide sur le mont Puget.

Les techniques géostatistiques et la modélisation à mésoéchelle répondent donc à des logiques et des approches différentes, mais permettent d’estimer une valeur en tout de point de l’espace. Leur utilisation dépend des problématiques des études menées à l’échelle locale et régionale. Ces méthodes ne s’opposent pas et sont au contraire complémentaires pour affiner la connaissance du climat passé, présent et futur.

Figure 20. Températures à 2 m au-dessus du sol le 12 décembre 2015 à 7h TU : carte issue d’un modèle à méso-échelle. L’axe rouge représente un transect entre la frange littorale et les premiers reliefs marseillais (distance : 5,7 km). Source : Christophe Yohia, OSU Institut Pytheas

Figure 20. Températures à 2 m au-dessus du sol le 12 décembre 2015 à 7h TU : carte issue d’un modèle à méso-échelle. L’axe rouge représente un transect entre la frange littorale et les premiers reliefs marseillais (distance : 5,7 km). Source : Christophe Yohia, OSU Institut Pytheas

Sommaire du cahier